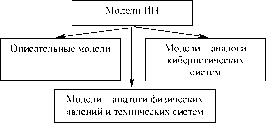

Теоретико-информационные модели

Многие из используемых аналогий достаточно условны и адекватность допущений действительным закономерностям, имеющим место в биосистемах, может вызывать оправданные возражения.

Модель 5.1. (С. Дейч [35]).

О. В некоторых моделях нервной системы мозг рассматривается как техническая система распознавания образов, параметры которой зависят от электрических характеристик нервных волокон.

Г. Отросток нейрона - длинная RC-цепочка (RC-линия, состоящая из конденсатора и резистора).

Ф. Если Uin - напряжение на входе RC-цепочки, Uout(t) - напряжение на выходе, то связь между ними, в силу законов Кирхгофа, описывается дифференциальным уравнением:

C dUout (t) = Цгп - Uout (t) dt R ’

где C - емкость конденсатора, а R - величина сопротивления.

В. Выходное напряжение изменяется экспоненциально. Так как временные характеристики процессов передачи и распространения сигналов в нервной системе определяются экспоненциальными передаточными функциями с характерным временем t = R C то g = 1 /1 будет определять скорость переходных (адаптационных) процессов в системе, то есть описываться экспоненциальной зависимостью.

А. Различение амплитуды сигнала (стимула) в рассматриваемой модели описывается законом, практически совпадающим с законом Вебера-Фехнера [31, 35]. Выходное напряжение схемы -основная характеристика модели - удовлетворяет линейному дифференциальному уравнению (см. четвертый раздел). -

Модель 5.2.

О(Г). По аналогии с механизмами радиоактивного распада в физике, предположим, что рассогласование обучаемой системы определяется рассогласованием элементов, каждый из которых может иметь либо некоторое начальное рассогласование, либо некоторое конечное рассогласование.

Рассогласование системы-функция числа элементов, имеющих ненулевое рассогласование, причем уменьшение рассогласования, происходящее для каждого элемента скачкообразно, - вероятностный процесс, характеризуемый постоянной (не зависящей от времени и числа элементов) вероятностью g зануления рассогласования элемента в единицу времени.

Ф. Число элементов N(t), имеющих в момент времени t ненулевое рассогласование, удовлетворяет уравнению N(t + At) = N(t) - gN(t) At.

Переходя к пределу по At, получим дифференциальное уравнение

dN (t) dt

(5.1)

g N(t).

В. Решение уравнения (5.1) имеет вид (5.2) N(t) = No e- gt,

где N0 - число элементов в системе (в нулевой момент времени все элементы имели максимальное (начальное) рассогласование).

А. Постоянная g, характеризующая период полураспада, характеризует скорость научения. Чем больше вероятность уменьшения рассогласования элемента в единицу времени, тем выше скорость научения.

Отметим, что предположение об одинаковости для всех элементов и стационарности вероятности распада является существенным.

Важным представляется также то, что приведенному выше уравнению для N(t) удовлетворяют не только механизмы радиоактивного распада, но и процессы бактериального роста, фармакокинетические процессы, большинство кинетических схем химических реакций (в том числе - закон действующих масс) и др. Зависимость от времени макроскопических характеристик во всех этих случаях оказывается экспоненциальной просто потому, что поведение любого элемента носит вероятностный характер, причем статистические характеристики процессов (распада, роста, вступления в реакцию и т.д.) не зависят от времени и предыстории системы. Это утверждение о стационарности, лежащее в основе описания и объяснения упомянутого класса процессов, является согласованным с экспериментальными данными предположением. -

Модель 5.3.

О. Каждый элемент обучаемой системы имеет собственный регулятор, стремящийся уменьшить свое рассогласование. Рассогласование системы в целом - монотонная функция рассогласований элементов.

Г. Каждый регулятор характеризуется постоянной относительной ошибкой в (требовать постоянства абсолютной ошибки представляется нелогичным, так как регулятор должен быть универсальным [93]). На -ом шаге регулятор случайным образом переводит элемент из состояния хп_1 в состояние хп, равномерно распределенное в 8 = 8(хп_1)-окрестности нулевого рассогласования.

Ф(В, А). При достаточно большом п кривая научения - среднее рассогласование элементов - убывающая экспоненциальная функция. Вид КН обусловлен постоянством относительной ошибки регулятора и предположением о вероятностных распределениях (ср. с изменением информации при измерении величин с погрешностью [21, 22]). -

Модель 5.4.

О(Г, Ф, В). Обучаемая система представляет собой набор регуляторов первого порядка (то есть апериодических звеньев первого порядка, осуществляющих регулирование по величине переменной и скорости ее изменения), аналогичных используемым в автоматическом регулировании. Передаточная функция (реакция на импульсное входное воздействие) каждого элемента:

h(t) = 1 - exp (- g t).

А. Интересно отметить, что апериодическое звено второго порядка (осуществляющее регулирование по значению переменной и первым двум ее производным), которое может рассматриваться как последовательное соединение двух апериодических звеньев первого порядка, имеет логистическую передаточную функцию. В рамках этой модели логистические кривые научения можно рассматривать как КН иерархической системы, состоящей из двух подсистем, результаты итеративного научения каждой из которых описывается экспоненциальной кривой. -

Модель 5.5. (Ю.Г. Антомонов [10]).

О. Исследуются вероятности нахождения системы в определенных состояниях. Пусть у обучаемой системы имеются два возможных структурных состояния s1 и s2. Обозначим вероятности нахождения системы в этих состояниях p = Prob {s1} и

dp(t)

q = Prob {s2}; q = 1 -p; p’ = -.

dt

Г. По аналогии с механическими системами предположим, что система описывается двумя функциями времени, одну из которых условно назовем уровнем организации (потенциалом) системы:

(5.3) V(t) = a p2(t),

а вторую - кинетической энергией системы:

(5.4) T(t) = j (p)dt.

Отметим, что V(t) и T(t) соответствуют потенциальной и кинетической энергии механической системы, фазовой переменной которой является p(t). Функция K = T- V - полная энергия системы.

Далее введем следующее предположение: Для того, чтобы динамический процесс изменения уровня организации системы, в связи с внутренними причинами или действиями среды, был оптимальным, он должен, по-видимому, подчиняться принципу, аналогичному принципу наименьшего действия [10].

Ф. Подставляя (5.3) и (5.4) в уравнение Лагранжа и решая его, получим

(5.5) p(t) = 1 - e- 7 (, где

(5.6) у = a / /3.

В. Оптимальность живых систем заключается в экспоненциальных законах изменения вероятностей ... [10].

А. Следует признать, что на сегодняшний день описанная выше модель является одной из наиболее изящных и красивых (если эти термины могут относиться к математическим моделям).

Нисколько не умаляя достоинств модели и ее значения, попытаемся восстановить ход рассуждений ее автора.

Во-первых, известно из экспериментов, что вероятности в процессе ИН изменяются в большинстве случаев по экспоненциальному закону. Во-вторых, должны существовать общие законы функционирования живых систем.

Так как принцип наименьшего действия обладает достаточной общностью (по крайней мере, для механических систем), перенесем его и на живые системы.

А дальше все достаточно просто - записываем соответствующие уравнения и исследуем какова должна быть структура потенциала и кинетической энергии, чтобы решение удовлетворяло (5.5). Оказывается, что единственная конструкция, приводящая к требуемому результату - (5.3) и (5.4). Следует, правда, при этом отметить, что выбор начальных условий и (5.3)-(5.4) не тривиален.

Более того, затруднительны и содержательные интерпретации (5.6) как скорости научения.

На этой модели очень хорошо демонстрируется одновременное применение и прямого метода построения моделей ИН (когда вводятся предположения и из них делается вывод, совпадающий с экспериментальными данными), и обратного (в котором ищутся те предположения и гипотезы о механизмах функционирования исследуемой системы, приводящие к требуемому результату). -

Таким образом, рассмотренные выше модели итеративного научения, построенные по аналогии с принципами и законами функционирования физических и технических систем, используют обобщения ряда физических законов. Как правило, вводится предположение, что законы (в большинстве случаев - законы сохранения), сформулированные для определенного класса систем живой и неживой природы (и справедливые для описания обучаемых систем на определенном микроуровне рассмотрения), остаются справедливыми и для макроскопического описания этих систем.

Справедливость этого предположения в большинстве случаев, к сожалению, пока не подкрепляется экспериментальным подтверждением.

Теоретико-информационные модели

Значительную часть описанных в литературе моделей итеративного научения составляют модели, основывающиеся на рассмотрении процессов переработки информации в обучаемых системах. Объединяет эти теоретико-информационные модели то, что, практически, во всех из них предполагается, что возможности обучаемой системы по передаче и переработке информации (количество информации, передаваемой, обрабатываемой, усваиваемой и т.д. в единицу времени) ограничены [20, 45, 50, 110 и др.]. Так, например:

... среднее время, требующееся для четкого уяснения значения некоторого сигнала и правильной реакции на него, возрастает пропорционально средней информации, содержащейся в этом сигнале. Исходя отсюда, можно предположить, что в случае достаточно регулярно происходящих событий, характеризующихся определенной статистической устойчивостью, сообщение о возникновении такого события передается через органы чувств и центральную нервную систему в среднем за время, пропорциональное содержащейся в этом сообщении информации. ... передача сообщений в живом организме происходит так, что за одинаковое время в среднем передается одинаковое количество информации [95, с. 115].

Частным случаем предположения об ограниченности возможностей человека при переработке информации является известный закон Хика, устанавливающий пропорциональность (в определенном диапазоне) между количеством обрабатываемой информации и неопределенностью сигнала; при превышении последней некоторого порогового значения количество перерабатываемой информации остается постоянной.

Различают два типа информации - связанная (начальная, априорная информация, заложенная в структуре системы) и свободная. Процесс научения при этом может интерпретироваться следующим образом: ... свободная информация постепенно

переходит в связанную, происходит процесс научения - повышения первоначальной организации системы, наращивание объема связанной информации [40, с. 15]. Обучение может также пониматься как ... развитие системы без увеличения элементного состава, повышение ценности информации установлением дополнительных связей [37, с. 193], причем модификация структуры целей в большинстве случаев вызывает лишь количественные, а не качественные изменения [47, 55].

Информация, поступающая на вход системы или ее подсистемы может использоваться, в частности, следующим образом:

1) непосредственная реакция;

2) запоминание предыдущих ситуаций с целью отбора наиболее удачных реакций непосредственного типа;

3) запоминание внешних воздействий с целью их экстраполяции и выявления рациональной реакции на экстраполированное внешнее воздействие;

И, наконец, наиболее общий четвертый случай - создание моделей внешнего мира и получение прогноза на базе функционирования моделей [51].

Практически все рассматриваемые в настоящем разделе модели итеративного научения опираются на приведенные выше положения.

Модель 6.1. (Ю.Г. Антомонов [10]).

О. В работе [82] был предложен подход к определению понятия организации системы и ее сложности [44] через энтропию. Соответствие между сложностью и организацией системы и сложностью и организацией окружающей среды устанавливается принципом адекватности.

Известны различные формулировки принципа адекватности [7, 8, 41]. Например, возможности (сложность, пропускная способность и т.д.) управляющей системы определяют пределы управляемости объекта управления, как бы не были велики его собственные возможности (обратное соотношение встречается в биологии чрезвычайно редко). Другими словами, для того, чтобы система успешно функционировала в среде, сложность и организация ее должны быть адекватны сложности и организации среды

[9].

В [9] предложен принцип динамической адекватности : ... при изменении сложности и организации среды биосистема постоянно стремится достичь нового уровня адекватности по сложности и организации со средой с минимизацией времени, затрат вещества и энергии.

Г. В частности, в [9] вводится следующее предположение (которое в том или ином виде используется, практически, во всех теоретико-информационных моделях ИН): изменение энтропии в обучаемой системе - (количество информации, перерабатываемой получаемой, передаваемой и т.д. системой) пропорционально изменению энтропии окружающей среды.

Ф(В, А). Коэффициент пропорциональности зависит от возможностей системы - пропускной способности каналов передачи информации, максимально допустимой скорости изменения параметров элементов и т.д., причем, если коэффициент пропорциональности и количество информации, поступающей в единицу времени, постоянны (не зависят от времени), то динамика системы, очевидно, описывается экспонентой (см. ниже более подробно). Если обучение рассматривается как процесс получения информации, то в обучаемой системе происходит поэтапное устранение неопределенности за счет информации, поступающей из внешней среды [30, 41, 54, 78]. -

Модель 6.2. (Ю.В. Рублев, Г.Н.

Востров [74]).

О. Процесс переработки информации обучаемой системой.

Г. Предположим, что информационные потоки удовлетворяют уравнению

dJ

dI

dt

+ b J,

(6.1)

a dt

где I - количество поступающей информации, J - количество усваиваемой информации, a и f - константы, характеризующие обучаемую систему и определяющие скорость научения.

Уравнение (6.1) свидетельствует, что скорость усвоения информации пропорциональна скорости поступления информации и уменьшается (также пропорционально) с ростом уже полученной информации.

Предположим, что количество информации, поступающей в единицу времени постоянно:

(6.2) I(t) = ? t.

Ф(В). Решение (6.1) в рамках сделанного предположения имеет вид

(6.3) J(t) = 8 (1 - e -gt) где

(6.4) 8 = ?/$ g = b/ a.

А. Предположения о постоянстве (или ограниченности) количества информации, поступающей или перерабатываемой обучаемой системой в единицу времени, используются практически во всех теоретико-информационных моделях итеративного научения, причем в большинстве из них они имеют именно вид (6.2). В рассматриваемой модели для получения выражения (6.3) потребовалось введение достаточно конкретной гипотезы о связи поступающей и усваиваемой информации. Интересно отметить, что скорость обучения, определяемая константами а и $, не зависит от темпа поступления информации ? - внешнего параметра, а определяется только параметрами самой системы. -

Модель 6.3. (В.Ф. Присняков, Л.М. Приснякова [69, 70, 83]).

О. Запоминание и хранение информации в памяти человека. Г. Информационные потоки подчиняются соотношению

dI

dt

dJ

dt

(J - J~) / T,

(6.5)

dJ

dt

где J - количество усваиваемой информации,

- темп усвоения

информации, - темп подачи информации, T - постоянная dt

времени (характерное время, определяющее скорость научения) процесса переработки информации памятью человека, J - предельное значение усвоенной информации (ср. с (6.1)).

dI

Ф(В, А). В предположении = ? = Const (постоянство

dt

внешних условий), решение (6.5) имеет вид

(6.6) I(t) = 8 (1 - e- g),

где 8 = Г + ? T, g = 1 / T (ср. с (6.3)). -

Модель 6.4. (О.Ф. Шленский, Б.В.

Бодэ [90]).

О. Процесс накопления информации и ее забывания.

Г. При постоянном количестве информации, поступающей в единицу времени, идеальная память запоминает всю информацию. В реальной памяти количество запоминаемой в единицу времени информации убывает с ростом уже запомненной информации (замедленная асимптотичность).

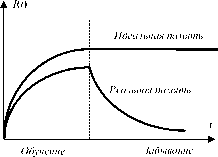

После окончания процесса обучения идеальная память сохраняет информацию неограниченно долго, а в реальной памяти количество информации после окончания процесса обучения монотонно убывает (забывание), причем текущая скорость забывания пропорциональна объему имеющейся на данный момент информации I(t) (замедленная асимптотичность, см. рисунок 6.1).

Ф(В, А). Если уравнение памяти представить линейным интегральным уравнением, то качественный вывод будет таким же, как и при использовании уравнений (6.1) и (6.5) в моделях 6.2 и 6.3 [90]. -

Модель 6.5. (В.А. Трапезников [76, 77]).

О. Переработка информации человеком-оператором.

Г(Ф, В, А). Экспоненциальная зависимость качества работы оператора в зависимости от времени обучения постулируется. -

Модель 6.6. (Г.П. Шибанов [89]).

0. Переработка информации оператором (в человекомашинной системе) при обучении и в процессе профессиональной деятельности.

Г. Количество информации I, перерабатываемой оператором в процессе его деятельности, соответствует изменению его энтропии: I = ЛИ. Следовательно, неупорядоченность деятельности оператора W (число возможных состояний научаемой системы, логарифм которого определяет энтропию) зависит от времени следующим образом:

(6.7) W(t) = Wo e -b‘.

Предположим, что I(t) = a t, где t - время обучения оператора, a - константа, характеризующая систему подготовки. Определим качество работы оператора следующим образом

Q(t) = Qmax (1 - W(t)).

Ф(В). Тогда

(6.8) Q(t) = Qmax (1 - Wo e-g) где g = a b.

А. Экспоненциальный характер КН обусловлен выбором энтропии и информации как характеристик неупорядоченности, конкретными (в частности, линейными) зависимостями характеристик деятельности оператора от неупорядоченности и предположением линейного увеличения количества накопленной информации. В рассматриваемой модели скорость научения зависит как от темпа поступления информации в процессе обучения, так и от характерного времени изменения неупорядоченности.

Следует отметить, что в [89] выделялись три этапа обучения:

1. Первоначальная приработка человека-оператора к данному режиму работы.

2. Отработка результативных характеристик в рамках фиксированного режима (собственно этап итеративного научения).

3. Деятельность, характеризуемая статистически стабильными характеристиками.

Зависимость ошибки от времени можно в этом случае схематично представить кривой, приведенной на рисунке 6.2. -

Модель 6.7. (В.М. Глушков [33]).

О. Переработка информации в процессе обучения перцептро-на (системы распознавания образов, которая может рассматриваться как модель запоминания и научения в живых системах).

Г. Для правильного распознавания /-го изображения необходимо и достаточно, чтобы оно было хоть раз показано перцептрону в процессе обучения.

Ф. При n случайных (равновероятных) показах изображений вероятность появления одного из N образцов составляет (1 - 1 / N)n @ exp ( - n / N).

В. Тогда полная эффективность обучения (вероятность правильного распознавания в зависимости от длительности этапа научения)

Рп = 1 - e ~g n.

где g = 1 / N.

А. Сравним с моделью 5.2. В данной модели, как и в 5.2, вероятность уменьшения рассогласования элементов (каждый элемент отвечает за запоминание одного образа) характеризуется постоянной вероятностью g зануления его рассогласования в единицу времени (вероятностью того, что соответствующий образ был показан и запомнен). Обучаемая система предполагается достаточно пассивной, поэтому скорость научения обратно пропорциональна числу возможных вариантов N. -

Модель 6.8.

О. Обучаемая система имеет канал связи, через который в процессе научения из внешней среды поступает информация, причем чем большая часть информации получена системой, тем меньше рассогласование.

Г. В канале связи, пропускная способность которого ограничена, присутствуют помехи [88]. На каждом шаге посылается вся информация, которая еще не получена системой, причем каждый раз система получает неискаженной лишь некоторую фиксированную ее часть.

Ф. Предположим, что для успешного научения система должна получить полную информацию I. На первом шаге посылается вся информация, неискаженной доходит gI (g 1).

На втором шаге посылается информация в объеме (1 - g) I, из которой система получает g(1 - g) I и т.д. Количество информации, полученной системой через n 2 шагов, определяется выражением

(6.8) Jn = (1 + (1 - g) + (1 - g)2 + ... + (1 - g)n-1) gl, то есть Jn = gI (1 - (1 - g)n).

Возможны и другие интерпретации. Пусть, например, на каждом шаге посылается вся информация I. Тогда количество полученной информации изменяется со временем следующим образом:

(6.9) J(t+Dt) = J(t) + g(I- J(t)) At.

В. Решение (6.9) имеет вид

(6.10) J(t) = I (1 - e- gt).

А. Такой вид решения обусловлен пропорциональностью количества новой информации, получаемой системой, тому количеству информации, которое осталось передать. Другими словами это свойство (предположение) можно интерпретировать следующим образом: способность системы усваивать (запоминать) информацию уменьшается пропорционально количеству запомненной и переработанной информации.

Критическим при этом (для того, чтобы решение имело вид, совпадающий с (6.10)) является то, что пропорция между получаемой частью информации и уже накопленной остается постоянной во времени. Следует отметить, что в рамках данной модели просто предположение об ограниченности пропускной способности канала связи привело бы к совершенно другим выводам (количество 44

накопленной информации росло бы линейно и т.д.). Скорость научения в рассматриваемой модели определяется пропускной способностью канала g - чем большая часть информации доходит без искажений, тем выше скорость научения. -

Модель 6.9.

О. Представим сложную обучаемую систему в виде множества элементов (их число обозначим N), совместные действия которых ведут к достижению некоторой фиксированной цели.

Предположим, что каждый элемент характеризуется конечным множеством его допустимых состояний Sj(t) (число элементов множества Sj равно nj(t)), в одном из которых он может находиться

в момент времени t, i = 1, п . Число независимых состояний системы в целом (описываемой перечислением состояний ее невзаимодействующих элементов) равно произведению числа допустимых состояний всех элементов.

Г. Предположим, что научение заключается в сведении числа допустимых состояний каждого элемента к некоторому минимуму, то есть в оставлении одного или нескольких фиксированных состояний, соответствующих решаемой задаче. Цель обучения для системы - минимизация числа ее допустимых состояний.

Уменьшение числа допустимых состояний каждого элемента происходит по мере получения им информации.

Энтропия i-го элемента (его неупорядоченность):

(6.11) tfj(t) = ln n(t).

Количество управляющей информации §(0, поступившей i-му элементу в момент времени t, идет на снижение неопределенности:

(6.12) = _ Xj(t), t 0.

at

Предположим, что существует абсолютный предел количества регулирующей информации, поступающей в каждый момент: ?(t) Yu t 0. В общем случае, в момент времени t, §(0 принадлежит отрезку [0; gj] (X(t) 0 соответствует тому, что i-ый элемент в момент t не обучается).

Ф. Исследуем, как будет изменяться со временем число допустимых состояний элементов. Подставляя (6.11) в (6.12) и решая соответствующее дифференциальное уравнение, получим

(6.13) ni (t) = n0 exp ( - JXi(t), i = 1, n, t 0,

о

где n(0 - число допустимых состояний i-го элемента до начала научения. Интеграл в показателе экспоненты соответствует накоп-

t

ленной элементом информации Ii(t) = J x (t)dr.

о

В. Рассмотрим как будет вести себя во времени число допустимых состояний системы в целом, отражающее, в силу введенного выше предположения, эффективность научения: